Har du hört talas om Google BERT eller ALBERT? Brath förklarar Googles nya neuronnät

Caroline Danielsson

Caroline Danielsson

Google gör konstant förändringar och uppdateringar av sina algoritmer. De flesta är så pass små att de inte ens berättar om dem, de är bara en del av det dagliga arbetet på Google. Men sedan dyker det upp större uppdateringar, kärnuppdateringar (core updates), och nya funktioner som får sina egna namn. Det är dessa uppdateringar och förändringar som vi SEO:are är mest intresserad av. Och en av de allra senaste namngivna förändringarna har fått namnet BERT.

BERT är en akronym som betyder: Bidirectional Encoder Representation from Transformers. Det är en väldigt teknisk term som innebär att de har hittat ett nytt sätt för Google att förstå naturligt språk och att sökmotorn kan lära sig själv. Just nu har BERT inte rullat ut på alla språk, men det är bara en tidsfråga innan den implementeras på svenska Google.

BERT har faktiskt varit en stor del av språkteknologikretsar i ett års tid, men det är inte förrän nu som den går live på Google. Det är också värt att nämna att BERT är open-sourced, koden är helt gratis för andra att använda i sina egna system.

Enligt Google kommer BERT att påverka upp till 10% av alla sökningar, men frågan är om det gör en så stor skillnad för dig som sajtägare?

Hur fungerar BERT

Först ordet i akronymen ger oss en hint om vad den gör: bidirectional. Ett vanligt sätt för att lära en dator ett språk är en rak sekvens av ord, från vänster till höger eller höger till vänster. Dubbelriktad (bidirectional) språkinlärning innebär att datorn använder sig av alla omkringliggande ord för att lista ut vad meningen betyder.

Exempel: ordet “tomten” kan betyda en magisk man i röd dräkt eller marken där ditt hus står. I sökfrågan “hur mår tomten efter jul” kan vi människor lista ut innebörden tack vare kontext. Ett enkelriktat språkinlärningssystem kan bara lista ut innebörden av “tomten” baserat på de ord som står före “tomten”. Därför kan du få både sökresultat som förklarar vilket BMI jultomten har och artiklar om hur du tar hand om gräsmattan på vintern.

Ett dubbleriktat system som BERT kan även ta till godo orden som kommer efter “tomten” och när den ser ordet “jul” i sökfrågan förstår den kontexten bättre och ger dig information om jultomtens välmående efter julruschen. BERT läser hela meningen på en gång och kopplar de olika orden till varandra.

BERT är ett komplement

BERT ersätter inte RankBrain, Googles första stora språklärande system. Istället kommer de arbeta i samspel och BERT kommer vara hjälpsam när det sker udda eller väldigt specifika sökfrågor, såsom sökfrågor där tolkning av prepositioner ändrar sökfrågans intention.

Förbättrad förståelse av sökfrågan

En av de viktigaste delarna i Googles sökmotor är att förstå vad sökfrågan handlar om. För att visa de bästa resultaten måste sökmotorn lära sig språket och tolka det korrekt.

Exempel: om du söker efter “bygga en vägg i trä” är sökmotorn väldigt duktig på att förstå innebörden. Den visar sajter som berättar hur man bygger en trävägg, men eftersom du inte har specificerat om det är en fasadvägg eller inomhusvägg kan båda dyka upp.

Men låt oss säga att du söker på “bygga en vägg utan trä”. Nu är du ute efter att bygga med lecablock eller använda stålreglar och gips men fortfarande så dyker samma artiklar upp med träväggskonstruktioner.

Tidigare har sökmotorn lagt för lite värde i ordet “utan” och andra prepositioner. Istället läser sökmotorn “bygga en vägg trä” och visar relevanta resultat för sökfrågan. Den tiden kan nu vara förbi tack vare BERT som förstår innebörden av “utan” och sorterar bort träsajterna ur sökresultatet.

Inte bara det, BERT har också fått toppresultat inom flera språkinlärningskategorier. Den kan attitydanalysera: det vill säga analysera texten för att bestämma om texten är positiv, negativ eller neutral. BERT förstår entiteter såsom koncept, färger, personer, saker och så vidare. Den klarade tester om textuella implikationer, det vill säga att förstå innebörden av något eller kunna gissa sig fram till fortsättningen. Och den kan sätta rätt semantisk etikett på olika delar av en mening, exempelvis om något representerar ett resultat eller är en agent.

Egentligen är BERT redan gamla nyheter – ALBERT är här

Vi vanliga dödliga har precis hört talas om denna nya supermaskin, men för techjättarna är BERT redan gamla nyheter. Eftersom koden är helt öppen för vem som helst, inklusive företag, att ladda ned, har många stora företag valt att skapa sin egen BERT. Vissa nya modeller har till och med fått bättre testresultat än original-BERT. Microsofts MT-DNN har exempelvis fått högre betyg.

Google själva har redan börjat bygga vidare på BERT tillsammans med Toyotas forskningsteam och skapad efterträdaren: ALBERT. ALBERT är snabbare och effektivare än BERT samt har löst en del problem som BERT har dragits med. Det har fortfarande inte kommit något officiell uttalande att ALBERT tar över så tills vidare är det BERT som gäller, samt alla dess nedskalade modeller som DistilBERT och FastBERT. Mest troligt har BERT skrivits om för att inkludera förbättringarna som finns i ALBERT.

Hur optimerar du för BERT?

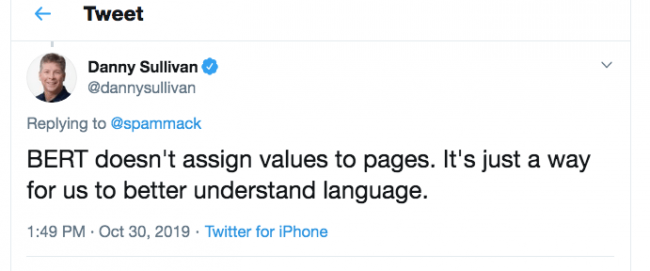

Det lätta svaret är: det gör du inte. Att optimera för en ny applikation har inget värde. BERT är till för att du som sajtägare ska dyka upp lättare på relevanta sökord och sökfrågor.

En fördel för dig som sökordsoptimerar är att du slipper bekymra dig av det linjära tänket när du jagar long tail-sökord. Nu behöver du inte offra god grammatik eller innehåll för att få in krångliga sökordsfraser.

Istället kan du fokusera helhjärtat på att göra det dina besökare och Google vill att du ska göra: producera och dela med dig av bra innehåll. Majoriteten kommer nog inte ens att märka av BERT. Det enda som kan hända är en liten sänkning i klickfrekvens då BERT ger mer korrekta sökresultat vilket innebär att den som söker inte behöver testa flera olika sajter innan de hittar informationen de vill ha. BERT kan också påverka featured snippets.